Llama 3 er Metas seneste store sprogmodel. Du kan bruge det til forskellige formål, såsom at løse dine forespørgsler, få hjælp til dine lektier og projekter i skolen osv. Når du installerer Llama 3 på din Windows 11-maskine lokalt, kan du bruge den når som helst, selv uden adgang til internettet. Denne artikel viser dig hvordan man installerer Llama 3 på en Windows 11 pc .

Sådan installeres Llama 3 på en Windows 11 pc

Installation af Llama 3 på en Windows 11 pc gennem Python kræver tekniske færdigheder og viden. Nogle alternative metoder giver dig dog mulighed for lokalt at implementere Llama 3 på din Windows 11-maskine. Jeg vil vise dig disse metoder.

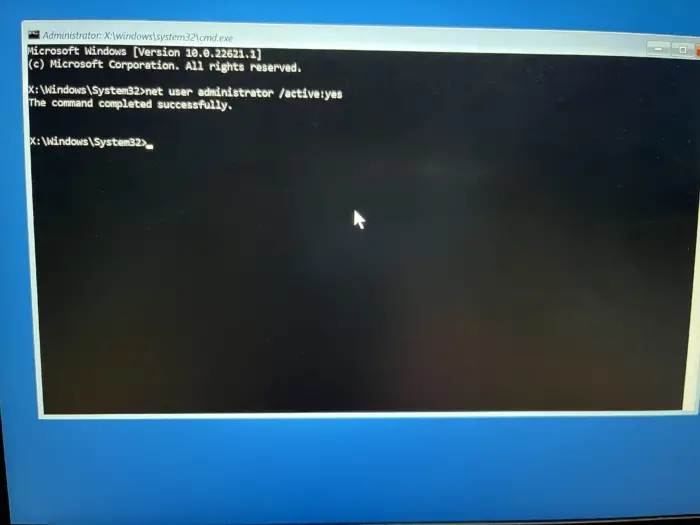

For at installere Llama 3 på din Windows 11-pc skal du udføre nogle kommandoer i kommandoprompten. Dette vil dog kun tillade dig at bruge dens kommandolinjeversion. Du skal tage yderligere skridt, hvis du vil bruge dens web-UI. Jeg vil vise dig begge disse metoder.

Implementer Llama 3 på Windows 11 pc via CMD

For at implementere Llama 3 på din Windows 11-pc skal du installere Ollama på din Windows-maskine. Trinene til det samme er som følger:

- Besøg Ollamas officielle hjemmeside .

- Klik på Download knappen og vælg derefter Windows .

- Klik nu på Download til Windows knappen for at gemme exe-filen på din pc.

- Kør exe-filen for at installere Ollama på din maskine.

Når Ollama er installeret på din enhed, genstart din computer. Den skal køre i baggrunden. Du kan se det i din systembakke. Klik nu på indstillingen Models på Ollama-webstedet. Du vil se dens forskellige modeller.

Llama 3.1 er tilgængelig i følgende tre parametre:

- 8B

- 70B

- 405B

Den sidste er den største parameter og kan naturligvis ikke køres på en low-end pc. Llama 3.2 har følgende to parametre:

- 1B

- 3B

Klik på den Llama-version, du vil installere på din pc. For eksempel, hvis du vil installere Llama 3.2, skal du klikke på Llama 3.2. I rullemenuen kan du vælge den parameter, du vil installere. Kopier derefter kommandoen ved siden af den og indsæt den i kommandoprompten.

For nemheds skyld har jeg skrevet begge kommandoer til Llama 3.2-modellen. For at installere Llama 3.2 3B-modellen skal du køre følgende kommando:

ollama run llama3.2:3b

For at installere Llama 3.2 1B-modellen skal du bruge følgende kommando:

ollama run llama3.2:1b

Åbn kommandoprompten, skriv en af de ovennævnte kommandoer (baseret på dine krav), og tryk Indtast . Det vil tage noget tid at downloade de nødvendige filer. Downloadtiden vil også afhænge af din internetforbindelses hastighed. Efter færdiggørelsen vil du se succes besked i kommandoprompten.

Skriv nu din besked for at bruge Llama 3.2-modellen. Hvis du vil installere Llama 3.1-modellen, skal du bruge de kommandoer, der er tilgængelige på Ollama-webstedet.

Næste gang du starter kommandoprompten, skal du bruge den samme kommando til at køre Llama 3.1 eller 3.2 på din pc.

hastighedstest, væddemål

Installation af Llama 3 gennem CMD har én ulempe. Det gemmer ikke din chathistorik. Men hvis du implementerer det på den lokale vært, vil din chathistorik blive gemt, og du vil få en bedre brugergrænseflade. Den næste metode viser, hvordan man gør det.

Implementer Llama 3 Web UI på Windows 11

Brug af Llama 3 på en webbrowser giver en bedre brugergrænseflade og gemmer også chathistorikken sammenlignet med at bruge den på CMD-vinduet. Jeg vil vise dig, hvordan du implementerer Llama 3 på din webbrowser.

For at bruge Llama 3 i din webbrowser, skal Llama 3 gennem Ollama og Docker være installeret på dit system. Hvis du ikke har installeret Llama 3 endnu, skal du installere den ved hjælp af Ollama (som forklaret ovenfor). Nu skal du downloade og installere Docker fra sin officielle hjemmeside .

Efter installation af Docker, start den og tilmeld dig for at oprette en konto. Docker kører ikke, før du tilmelder dig. Når du har tilmeldt dig, skal du logge ind på din konto på Docker-appen. Minimer Docker til systembakken. Docker- og Ollama-apps skal køre i baggrunden. Ellers kan du ikke bruge Llama 3 i din webbrowser.

Åbn nu kommandoprompten, kopier følgende kommando og indsæt den i kommandoprompten:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Ovenstående kommando vil tage noget tid at downloade de nødvendige ressourcer. Hav derfor lidt tålmodighed. Når kommandoen er fuldført, skal du åbne Docker og vælge Containere sektion fra venstre side. Du vil se en container oprettes automatisk med porten 3000:8080.

Klik på porten 3000:8080. Dette åbner en ny fane i din standard webbrowser. Tilmeld dig nu og log ind for at bruge Llama 3 på din webbrowser. Hvis du ser adresselinjen, vil du se lokalvært: 3000 der, hvilket betyder, at Llama 3 hostes lokalt på din computer. Du kan bruge den uden internetforbindelse.

Vælg din Llama-chatmodel fra rullemenuen. Hvis du vil tilføje flere chatmodeller af Llama 3, skal du installere det via Ollama ved hjælp af de nødvendige kommandoer. Herefter vil modellen automatisk være tilgængelig i din webbrowser.

Al din chathistorik vil blive gemt og tilgængelig i venstre side. Når du vil afslutte, skal du logge af din session i din webbrowser. Åbn derefter Docker-appen og klik på Stop knappen for at stoppe Docker. Nu kan du lukke Docker.

Når du vil bruge Llama 3 i din webbrowser næste gang, skal du starte Ollama og Docker, vente et par minutter og derefter klikke på porten i Docker-beholderen for at åbne localhost-serveren i din webbrowser. Log nu ind på din konto og begynd at bruge Llama 3.

Jeg håber, at dette hjælper.

Kan Llama 3 køre på Windows?

Afhængigt af din computers hardwarekonfiguration kan du køre Llama 3 på dit system. Dens 1B-model er den letteste. Du kan installere og køre det på dit system via kommandoprompten.

Hvor meget RAM skal jeg bruge til Llama 3?

Den letteste model af Llama 3 er Llama 3.2 1B. Dit system skal have 16 GB RAM for at køre Llama 3.2 1B-modellen. Ud over dette bør dit system også have en kraftig GPU. De højere modeller af Llama 3 kræver flere systemressourcer.

Læs næste : Sådan bruger du Leonardo Phoenix AI .